С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 25/03/15 в 12:56 Добавлено: 25/03/15 в 12:56 |

A-Parser - 1.1.224 - улучшенные возможности по уникализации результатов, множество исправлений

Все возможности новой версии можно протестировать в демо версии A-Parser'а

Улучшения

- Добавлена возможность уникализировать результаты созданные с помощью Конструктора результатов

- Добавлена возможность передавать дополнительные параметры на сервис распознавания каптчи(например специальные настройки для CapMonster)

- В парсер

SE::Bing::Images добавлена возможность отключить безопасный поиск SE::Bing::Images добавлена возможность отключить безопасный поиск

- В парсер

SE::YouTube добавлен фильтр по 4K видео SE::YouTube добавлен фильтр по 4K видео

- Добавлена возможность применять Конструктор запросов после подстановок запросов

- В парсер

SE::Bing добавлена возможность парсить связанные кейворды в глубину, автоматически подставляя новые кейворды в запросы(Parse to level) SE::Bing добавлена возможность парсить связанные кейворды в глубину, автоматически подставляя новые кейворды в запросы(Parse to level)

- Переработан выбор файлов запросов, теперь вложенные директории отображаются только при клике по ним

Исправления в связи с изменениями в выдачи

- Исправлен парсер

SE::Yandex::WordStat SE::Yandex::WordStat

- Исправлен парсер

SE::Yahoo SE::Yahoo

- Исправлен парсер

SE::AOL SE::AOL

- Исправлен парсинг связанных ключевых слов в парсере

SE::Bing SE::Bing

- Исправлен парсинг времени последнего кэширования страницы в парсере

SE::Yandex SE::Yandex

- Исправлен регистратор аккаунтов

SE::Yandex::Register SE::Yandex::Register

- Исправлен парсинг связанных ключевых слов в парсере

SE::Yandex SE::Yandex

Исправления

- Некорректно работала опция сохранения переноса строк для Windows (CRLF)

- Иногда задание могло зависнуть в состоянии pausing/stopping

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 05/05/15 в 06:05 Добавлено: 05/05/15 в 06:05 |

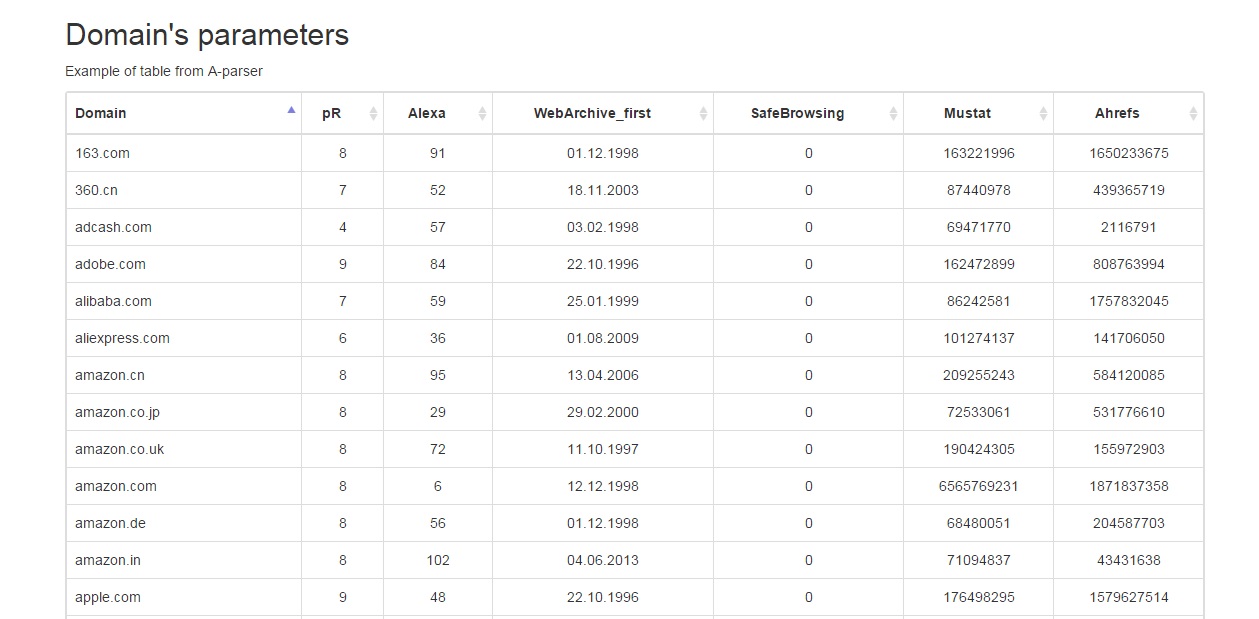

A-Parser - 1.1.247 - новые парсеры поисковиков Ask и Comcast, произвольные шаблоны в конструкторе результатов

Улучшения

- В конструкторе результатов и фильтрах теперь возможно использовать произвольный шаблон в качестве аргумента для преобразования или фильтрации

- В парсер

SE::Yandex добавлена возможность выбора домена yandex.com для парсинга SE::Yandex добавлена возможность выбора домена yandex.com для парсинга

- Добавлен новый поисковик

SE::Ask с американской выдачей Google SE::Ask с американской выдачей Google

- Добавлен новый поисковик

SE::Comcast с американской выдачей Google SE::Comcast с американской выдачей Google

- Добавлена статистика для завершенных заданий, а также отображение общего времени выполнения задания

- Добавлен объект $request, который доступен при форматировании результата и позволяет извлечь любую информацию о текущем запросе, а также о всех редиректах выполненных перед конечным запросом

Исправления

- Парсер мог заблокировать файл результата после завершения задания

- Исправлена некорректная обработка <base href= в некоторых случаях

- Парсер вылетал при использовании инструмента генерации произвольного User-Agent tools.ua.random() в тестовом парсинге

- В быстром задании не работал выбор запросов из файла

- Некорректно обрабатывался редирект с автоматическим выбором схемы(ссылки вида //domain.com/)

Исправления в связи с изменениями в выдачи

- В парсере

Rank::Alexa исправлен парсинг страны и регионального рейтинга Rank::Alexa исправлен парсинг страны и регионального рейтинга

- Улучшен парсинг тИЦ в парсере

SE::Yandex::TIC SE::Yandex::TIC

- Исправлен парсер

SE::Yahoo SE::Yahoo

- Исправлено определение блокировки IP-адреса в парсере

Rank::Ahrefs Rank::Ahrefs

- Исправлен парсер

SE::Yandex::WordStat::ByDate SE::Yandex::WordStat::ByDate

- Парсер

Rank::Category перешел на семантический анализатор от Ашманова Rank::Category перешел на семантический анализатор от Ашманова

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 19/05/15 в 10:20 Добавлено: 19/05/15 в 10:20 |

Программа LinkAParser - объединение функционала генератора PandoraBox и парсера A-Parser

С помощью данного софта задействованы основные возможности парсера A-Parser при генерации сайтов программой PandoraBox.

Обсуждение на форуме A-Parser'а и ссылка на сайт генератора

Применяет возможности А-Парсера для:

- Парсинга релевантного текста

- Парсинга релевантных картинок

- Парсинга релевантных видео роликов

Понимает какие ключи уже обработаны и не парсит одно и тоже дважды

С программой идут готовые пресеты, которые достаточно импортировать и можно запускать генерацию

Спаршенные данные программа структурировано раскладывает в файлы и папки

Спаршенный текст программа чистит от мусора по множеству признаков

В комплекте с программой идет набор дополнительных макросов:

- Макрос вывода релевантного текста с подмешанными ключами

- Макрос вывода релевантного текста без ключей

- Макрос вывода релевантной картинки

- Макрос вывода релевантной картинки как локальной(проксирование скриптом)

- Макрос вывода релевантного видео ролика

Для работы необходима лицензия парсера A-Parser Enterprise

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 27/05/15 в 11:55 Добавлено: 27/05/15 в 11:55 |

Сборник рецептов #3: мобильные сайты, несколько парсеров, позиции ключевых слов

Итак, продолжаем серию статей с рецептами применения A-parser: комплексные примеры с одновременным использованием различного функционала парсера.

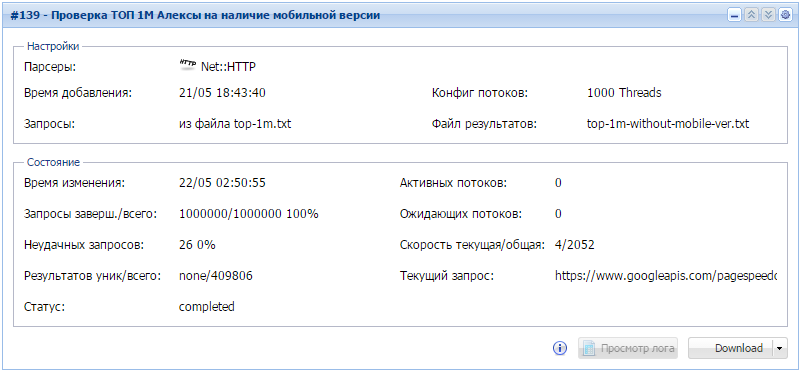

Проверяем наличие мобильной версии для 1000000 сайтов

Работаем с большими объемами данных и учимся искать совпадения в raw data.

- за 8 часов работы данного задания мы узнали что почти 41% самых посещаемых сайтов не имеют мобильных версий. Кто знает, возможно обзаведясь мобильной версией, они стали бы еще более посещаемыми?

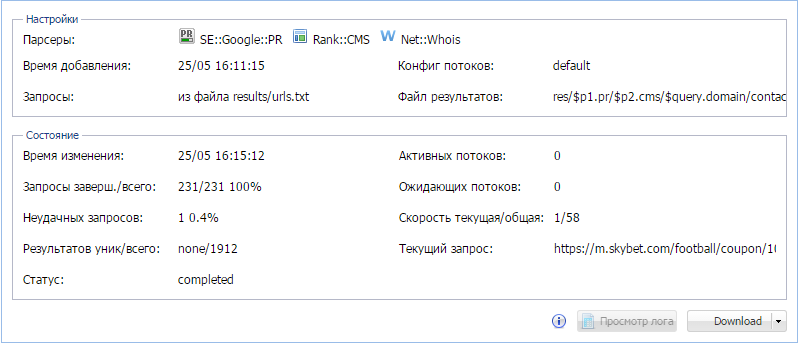

По списку запросов получаем страницы, CMS, PR, e-mail из whois

Комплексное задание, выполняемое в 2 этапа, в котором мы учимся работать с несколькими парсерами, регулярными выражениями, а также красиво выводим результаты во многоуровневые каталоги и несколько файлов.

- на первом этапе используется 1 парсер, на втором - 3

- в конструкторе результатов используется регулярное выражения для извлечения необходимой информации

- результаты выводятся в виде вложенных папок и текстовых файлов по следующей схеме:

| Код: | PR_1

\Joomla

\domain.com

contacts.txt

cache.txt

\Drupal

\WordPress

\no CMS

PR_2

PR_3 |

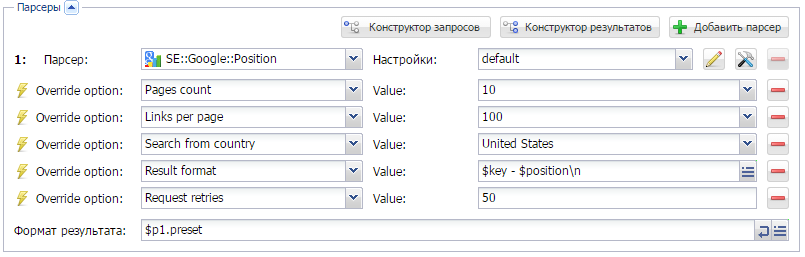

Узнать позиции по кеям, как?

Знакомимся с парсером  SE::Google::Position и проверяем на каком месте в поисковой выдачи находится ключевое слово.

Детальнее о самом парсере здесь.

Предыдущие сборники:

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 02/06/15 в 12:30 Добавлено: 02/06/15 в 12:30 |

Сборник рецептов #4: поиск в выдаче, парсинг интернет-магазина и скачиваем файлы

Очередной, 4-й выпуск сборника рецептов. Поехали!

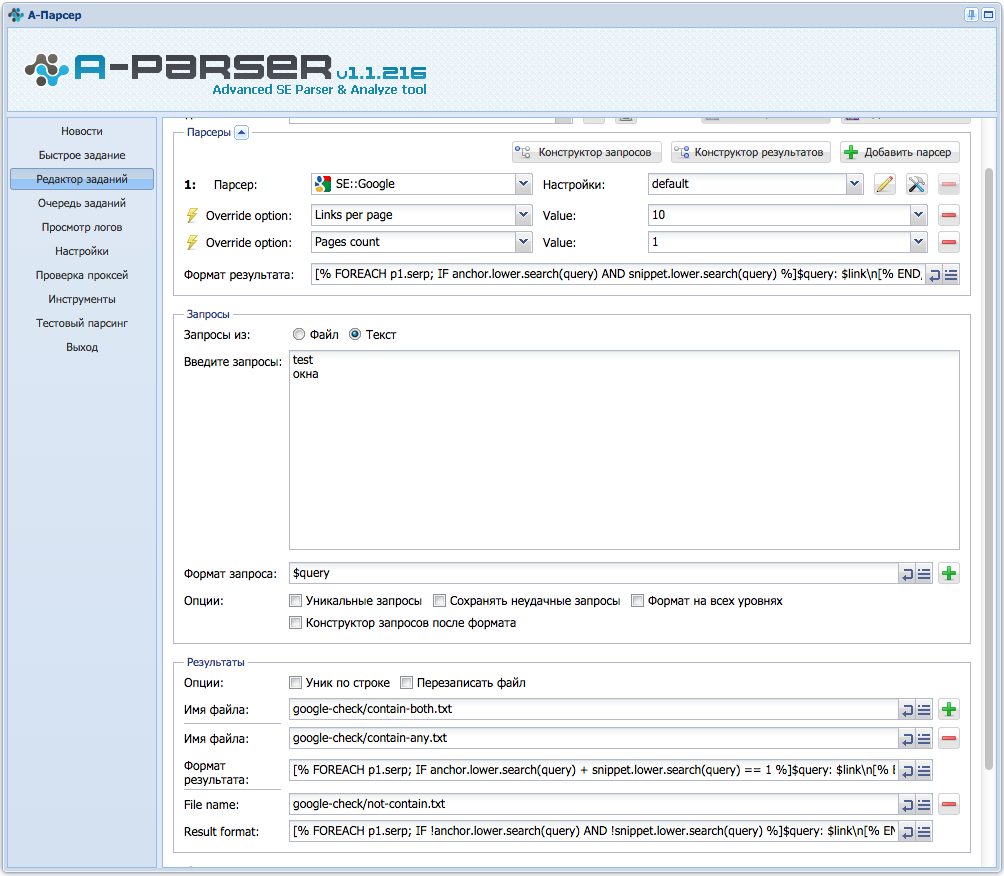

Анализ выдачи гугла на наличие ключа в тайтле и дескрипшене

Пользуемся возможностями шаблонизатора Template Toolkit. Используем циклы и поиск. А также сохраняем разные результаты в разные файлы.

В данном примере осуществляется поиск ключа в анкорах и сниппетах, и в зависимости от результата, сохраняет их в 1 из 3 соответствующих файлов. Все подробности, а также сохранение в 4-ре файла по ссылке выше.

Парсинг товаров с сайта

Парсим интернет-магазин и формируем свою HTML-страницу с результатами.

Суть задания заключается в том, чтобы спарсить названия и характеристики товара из интернет-магазина, сохранив привязку к категории и фото товара. Как все это сделать - по ссылке выше.

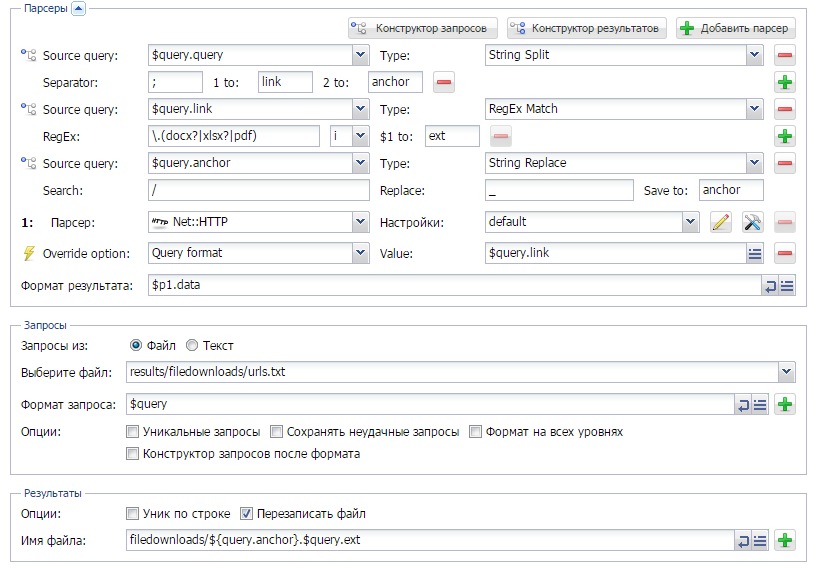

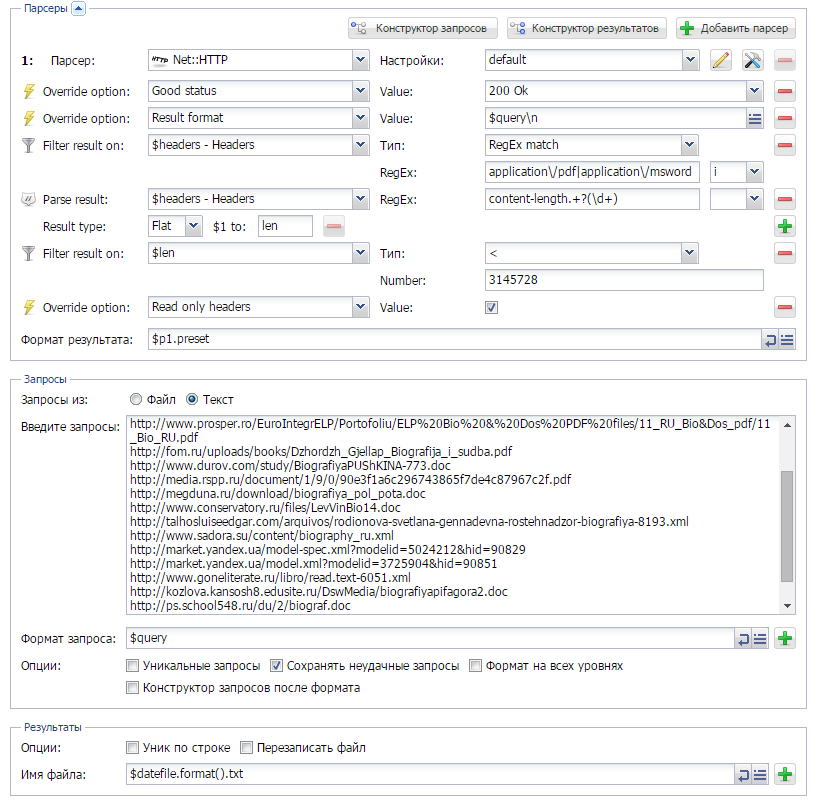

Скачиваем файлы

Сохраняем на жесткий диск различные документы из поисковой выдачи, с определением их типа, а также возможностью формировать уникальное имя файла.

Ну а здесь нам необходимо парсить из выдачи Гугла ссылки на документы формата doc, xls и pdf. Так же необходимо скачивать данные документы, при этом обеспечить уникальность имени файла. Детали - по ссылке выше.

Предыдущие сборники:

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 18/06/15 в 13:28 Добавлено: 18/06/15 в 13:28 |

Сборник рецептов #5: ссылки из JS, паблик прокси и карта сайта

5-й выпуск сборника рецептов. Здесь мы научимся парсить ссылки из страниц, где их подгружает JS-скрипт, будем собирать паблик прокси и составлять карту сайта.

Подгрузка ссылок через JS

Есть очень много сайтов, где контент загружается специальным скриптом (AJAX). К примеру, это может быть поиск на сайте. И как спарсить с таких сайтов информацию? Ведь если посмотреть код страницы в браузере - то, к примеру, ссылки там есть, а парсер их не видит... Решение есть, и оно довольно не сложное. Как это сделать - по ссылке выше.

Сборщик паблик прокси: как лучше и насколько это эффективно

Сборщик паблик прокси: как лучше и насколько это эффективно

Всем известно, что в интернете есть очень много сайтов, где выкладывают публичные прокси ( что это на Википедии). Если возникает необходимость в использовании таких прокси - появляется проблема в их сборе, при этом, естественно нужны только живые. Наверное так же известно, что используя А-парсер, можно их собирать. А вот как это делать и насколько это эффективно - читайте по ссылке выше.

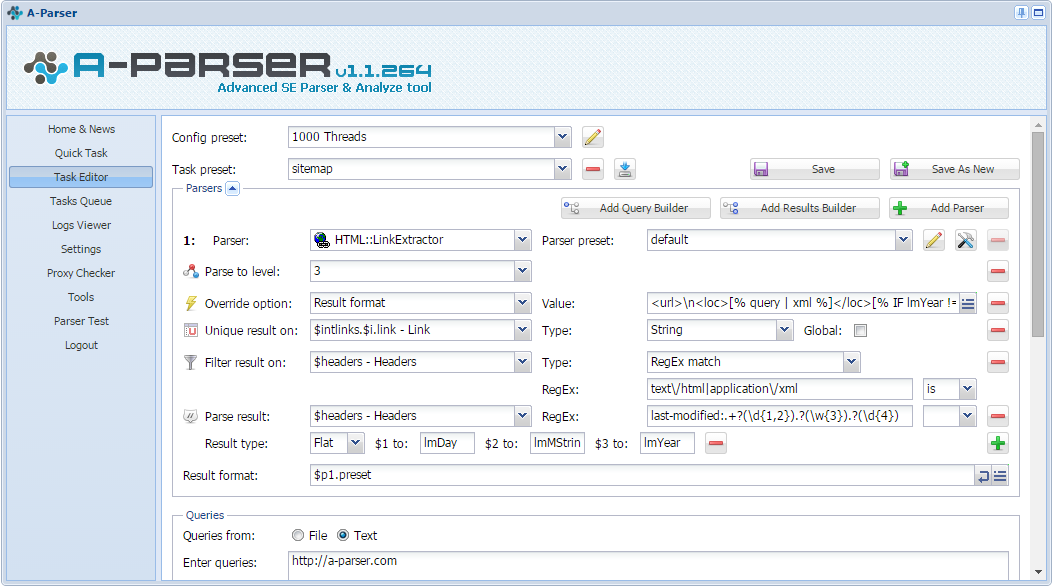

Карта сайта с помощью A-parser

Карта сайта с помощью A-parser

Карта сайта простыми словами - это XML-файл, который помогает поисковикам лучше индексировать сайт. Некоторые SEOшники считают ее отсутствие грубейшей ошибкой. Существует очень много сервисов и инструментов для создания таких карт, ну а мы попробуем создать ее с помощью A-parser. Что из этого получится, и как это делать - читайте по ссылке выше.

Предыдущие сборники:

Предыдущие сборники:

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 10/07/15 в 10:32 Добавлено: 10/07/15 в 10:32 |

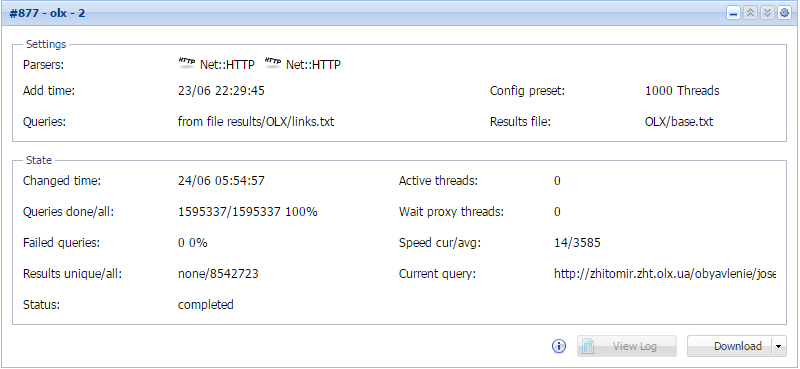

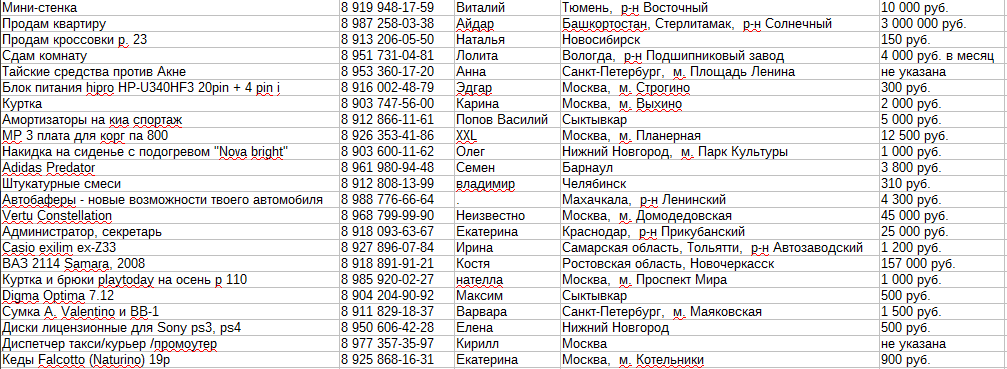

Сборник рецептов #6: парсим базу номеров телефонов и сохраняем результаты красиво

6-й выпуск сборника рецептов. Здесь мы попробуем собирать скрытые номера мобильных телефонов из доски объявлений и научимся сохранять результаты работы А-парсера в таблицы с возможностью сортировки.

Парсим базу мобильных телефонов

Базы телефонов могут использоваться по-разному, но основной вид их использования - рассылка смс рекламного характера. А если базу еще и возможно отсортировать по городу, интересу или другим характеристикам, т.е. сделать таргетированную рассылку, то эффективность сильно возрастает. Подобные базы собираются разными способами, мы же поговорим о том, как это сделать с помощью А-парсера.

Вывод результатов в таблицу

Вывод результатов в таблицу

Бывает, возникает необходимость в красивом и удобном выводе данных, полученных в результате парсинга. И если обычного текстового вида недостаточно, нужно искать другие способы вывода. Об одном таком способе и пойдет речь в статье по ссылке выше.

Предыдущие сборники:

Предыдущие сборники:

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 22/07/15 в 12:00 Добавлено: 22/07/15 в 12:00 |

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 04/08/15 в 11:24 Добавлено: 04/08/15 в 11:24 |

Сборник рецептов #7: парсим RSS, качаем картинки и фильтруем результат по заголовкам

7-й выпуск сборника рецептов. Здесь мы рассмотрим вариант парсинга RSS, будем скачивать картинки в зависимости от их характеристик и научимся фильтровать результат по хедерам.

Парсинг RSS

На сегодняшний день RSS остаются довольно популярным вариантом доставки новостей и контента пользователям. В связи с этим его используют почти на всех сайтах, где бывает более-менее периодическое обновление информации. А для нас это возможность быстро спарсить свежие обновления сайта, не анализируя сам сайт. И один из способов, как это сделать описан по ссылке выше.

Как фильтровать результат по определенным хедерам?

Как фильтровать результат по определенным хедерам?

Как известно, А-парсер предназначен для парсинга, в основном, текстовой информации. Но кроме этого им вполне реально парсить и другие обьекты (файлы, картинки и т.п.). При этом существует возможность фильтровать их по заголовкам ответа сервера. Об этом по ссылке выше.

Скачивание картинок указанного разрешения и размера

Скачивание картинок указанного разрешения и размера

Если выше мы фильтровали результат только по хедерам и рассматривали вариант с документами, то в данной статье мы будем скачивать картинки и фильтровать их по размеру и разрешению. Как это сделать - можно увидеть по ссылке выше.

Еще больше различных рецептов в нашем Каталоге примеров!

Еще больше различных рецептов в нашем Каталоге примеров!

Предыдущие сборники:

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 18/08/15 в 09:54 Добавлено: 18/08/15 в 09:54 |

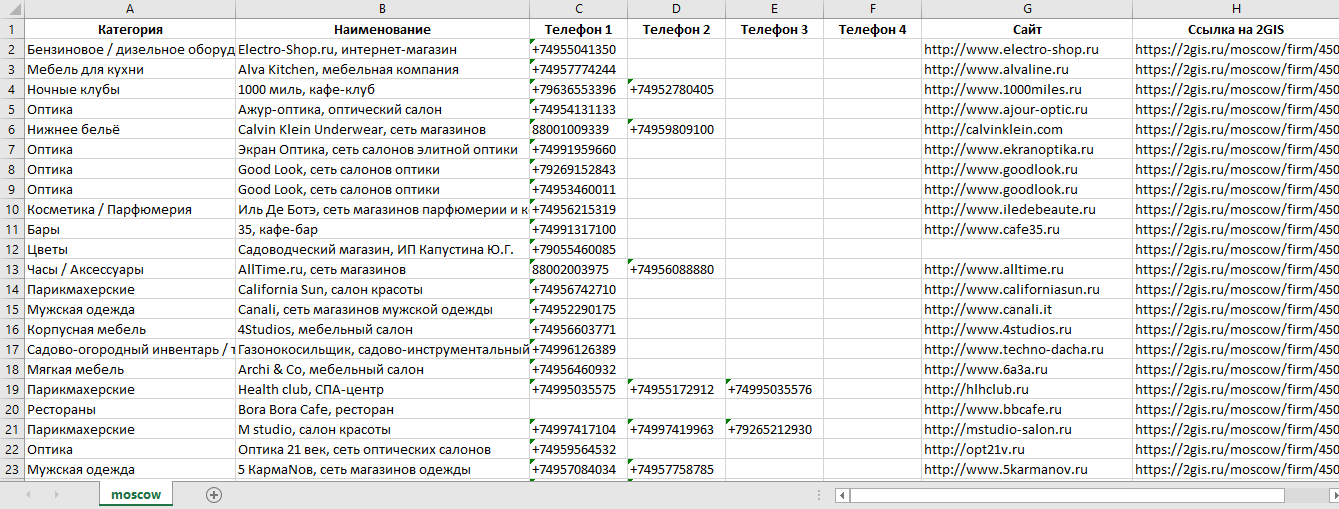

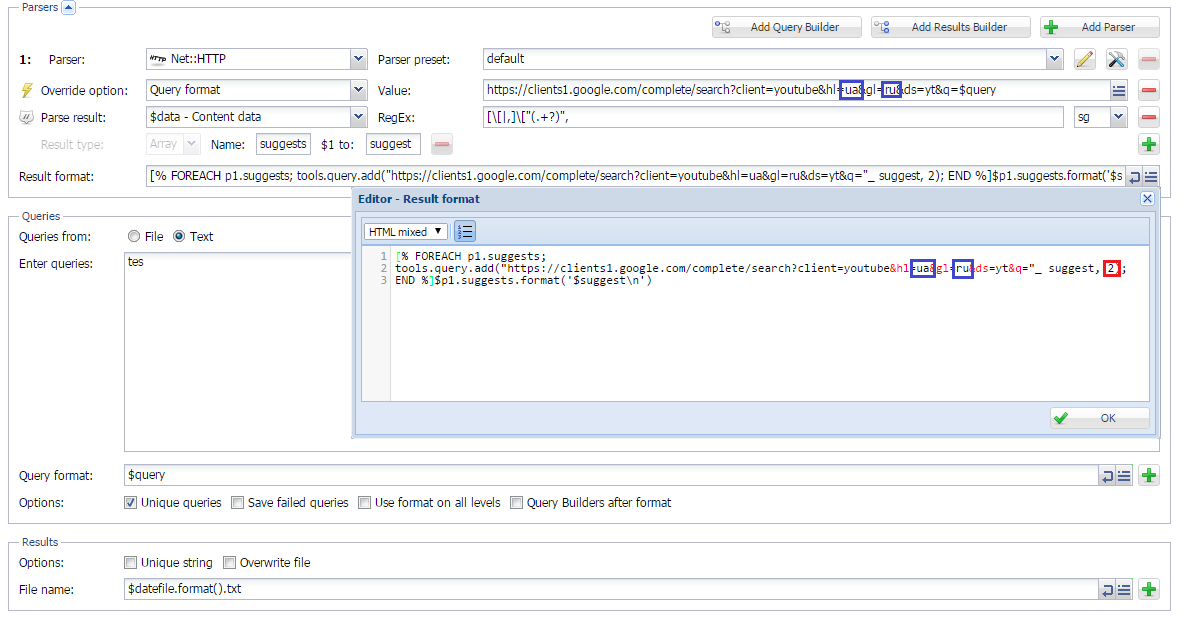

Сборник рецептов #8: парсим 2GIS, Google translate и подсказки Youtube

8-й выпуск сборника рецептов. В нем мы будем парсить базу организаций из каталога 2GIS, научимся парсить подсказки из Youtube и напишем кастомный парсер Google translate.

Парсинг 2GIS

2GIS - это довольно большой справочник организаций России (и не только...) с возможностью просмотра их расположения на карте. База содержит более 1580000 организаций в 270 городах России. После парсинга представляет интерес как справочник сайтов, электронных адресов и телефонов организаций.

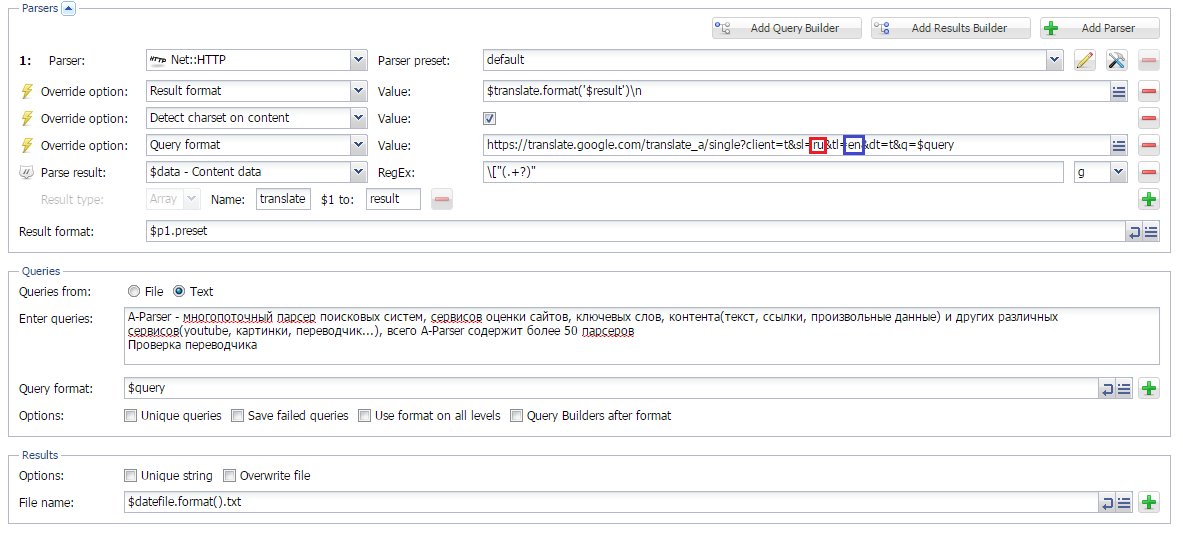

Парсинг Google Translate

Парсинг Google Translate

В данной статье рассмотрен способ написания кастомного парсера Google translate на основе  Net::HTTP. Также реализована возможность задавать направление перевода. Можно использовать для пакетного перевода больших обьемов текста.

Парсинг подсказок Youtube

Парсинг подсказок Youtube

Парсинг подсказок поисковых систем - довольно популярный способ поиска ключевых слов. В данной статье также используется  Net::HTTP, с помощью которого создается кастомный парсер подсказок Youtube. Реализована возможность задавать язык и страну, а также использовать уже спаршенные подсказки в качестве новых запросов на нужную глубину.

Еще больше различных рецептов в нашем Каталоге примеров!

Еще больше различных рецептов в нашем Каталоге примеров!

Предыдущие сборники:

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 16/09/15 в 07:06 Добавлено: 16/09/15 в 07:06 |

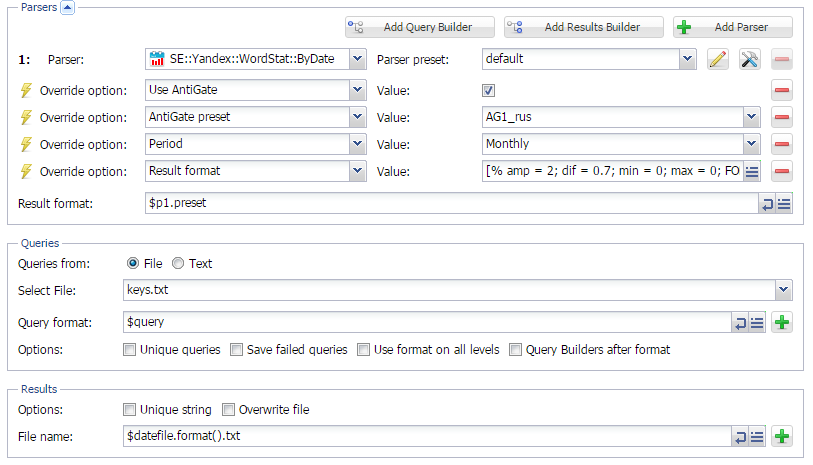

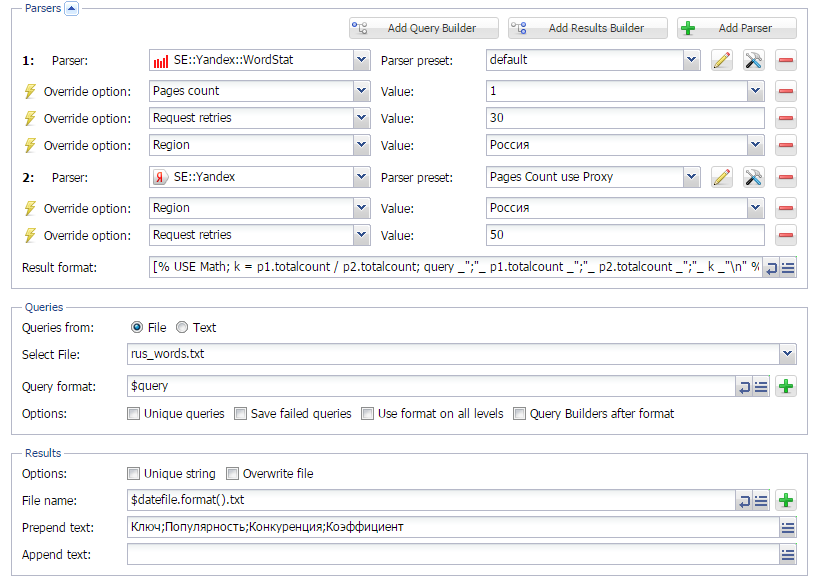

Сборник рецептов #9: проверяем сезонность ключевых слов и их полезность

9-й выпуск Сборника рецептов. В нем мы будем работать с ключевыми словами: проверять их сезонность и искать свободные ниши в рунете, проверяя "полезность" ключевиков.

Определение сезонности ключевых слов через Wordstat

Использование нужных ключевых слов в нужное время - один из способов привлечения дополнительного трафика на сайт. Для определения сезонности ключевых слов существует немало различных способов и сервисов. О том, как это делать с помощью А-Парсера - читайте по ссылке выше.

Поиск свободных ниш в RU сегменте интернета

Поиск свободных ниш в RU сегменте интернета

Используя на сайте не только сезонные, а и "полезные" ключевые слова, можно значительно повысить шансы попасть в ТОП10 поисковиков. И если о сезонности мы писали ранее, то о "полезности", а точнее о "незанятости" ключевых слов мы поговорим в данной статье. Полезные или незанятые - это такие КС, которые пользователи часто ищут, но конкуренция по которым не очень высокая. Как их искать - читайте по ссылке выше.

Еще больше различных рецептов в нашем Каталоге примеров!

Предыдущие сборники:

Еще больше различных рецептов в нашем Каталоге примеров!

Предыдущие сборники:

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 07/10/15 в 06:20 Добавлено: 07/10/15 в 06:20 |

A-Parser - 1.1.292 - парсинг JSON, улучшения использования памяти, множество исправлений

Улучшения

- Поддержка разбора JSON структур в шаблонизаторе

- Добавлена опция "Конструктор запросов на всех уровнях", позволяющая использовать конструктор запросов на всех уровнях вложенного парсинга

- При просмотре статистики работы задания теперь отображается общее число HTTP запросов

- Новый инструмент отладки Gladiator, позволяющий быстро локализовать возможные утечки памяти

Исправления в связи с изменениями в выдачи

- Исправлено определение наличия каптчи на этапе логина в парсере

SE::Yandex::WordStat SE::Yandex::WordStat

- Полностью переработан

Rank::Ahrefs Rank::Ahrefs

- Исправлен парсинг времени кэширования в

SE::Yandex SE::Yandex

- Исправлен

SE::Google::Images SE::Google::Images

- Исправлен

SE::Bing SE::Bing

- Исправлен

SE::Yahoo::Suggest SE::Yahoo::Suggest

- Исправлен

SE::AOL SE::AOL

Исправления

- Исправлен парсер

SE::Yandex::TIC - ресурсы у которых тИЦ был неопределен отображались как тИЦ = 0, исправлено на тИЦ = -1 SE::Yandex::TIC - ресурсы у которых тИЦ был неопределен отображались как тИЦ = 0, исправлено на тИЦ = -1

- Исправлено множество утечек памяти

- При замене в регулярных выражениях не работал символ переноса \n

- При использовании большого числа переменных в конструкторе запросов или результатов они могли не влезать в видимую область

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 14/10/15 в 08:31 Добавлено: 14/10/15 в 08:31 |

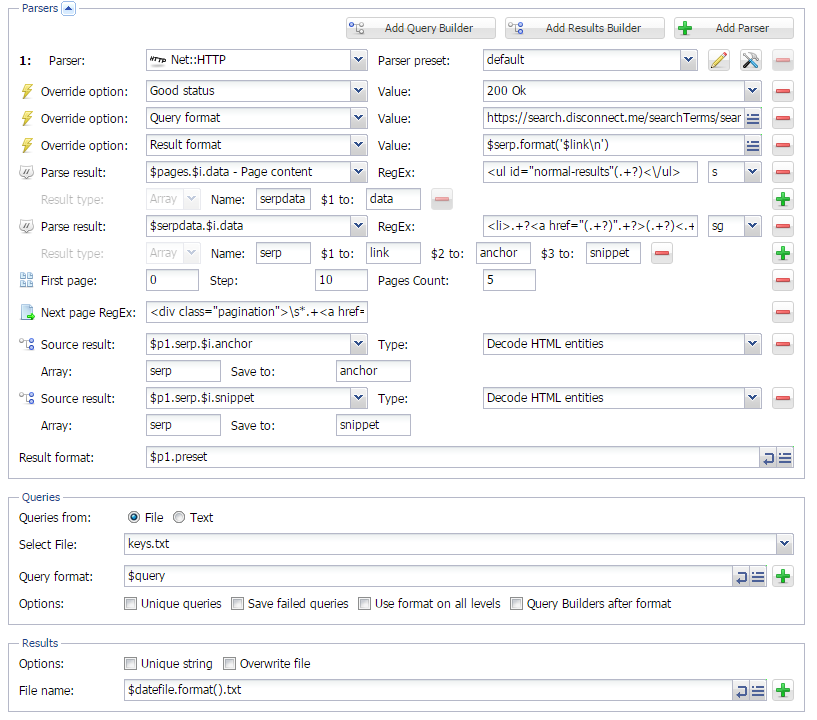

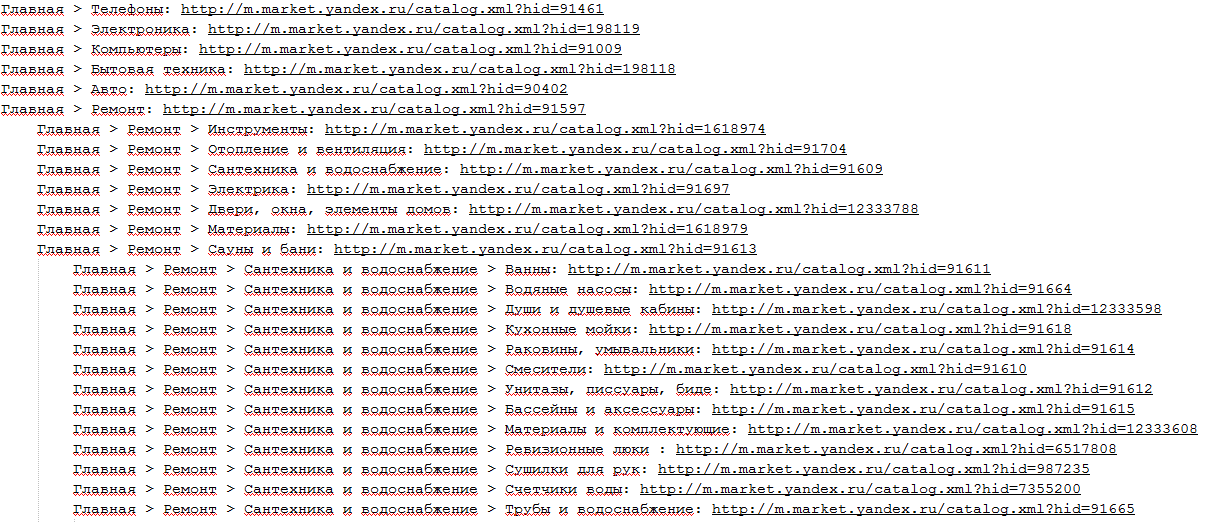

Сборник рецептов #10: пишем кастомный парсер поисковика и парсим дерево категорий

10-й выпуск Сборника рецептов. В нем мы сделаем кастомный парсер поисковика search.disconnect.me и научимся парсить категории из сайтов с сохранением иерархии и путей к ним.

Парсер search.disconnect.me или альтернатива inurl Google

В одном из сообщений на форуме был упомянут довольно интересный сервис search.disconnect.me. Также в последнее время все чаще стали появляться сообщения о проблемах при парсинге Гугла с поисковыми операторами. А так как вышеупомянутый сервис позволяет парсить Гугл, при этом не выдавая каптч и без бана прокси, можно попробовать сделать для него парсер на основе  Net::HTTP. Что из этого получилось - можно посмотреть по ссылке выше.

Парсинг дерева категорий с сохранением структуры

Парсинг дерева категорий с сохранением структуры

В версии 1.1.292 появилась новая опция Query Builders on all levels. С ее помощью можно регулировать, когда применять Конструктор запросов при парсинге "в глубину". И благодаря этой опции стало возможным парсить дерево категорий из сайтов с сохранением структуры. Как это работает - можно посмотреть по ссылке выше.

Еще больше различных рецептов в нашем Каталоге примеров!

Предыдущие сборники:

Еще больше различных рецептов в нашем Каталоге примеров!

Предыдущие сборники:

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 22/10/15 в 10:26 Добавлено: 22/10/15 в 10:26 |

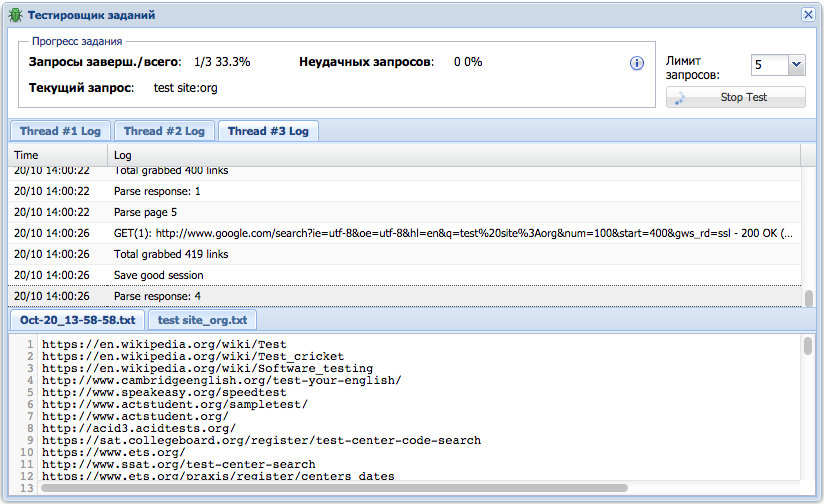

A-Parser - 1.1.323 - парсинг с помощью XPath, поддержка JavaScript в шаблонизаторе, тестировщик заданий

Улучшения

- Добавлен новый Тестировщик заданий, позволяющий тестировать все задание целиком, включая использование нескольких парсеров, конструкторов запросов и результатов. Тестировщик позволяет просматривать результаты по каждому созданному файлу, а также отображает логи выполнения по каждому запросу

- Для парсера

Net::Whois добавлена опция Recursive query, которая позволяет получать расширенную версию WHOIS(контактные email адреса и т.п.) Net::Whois добавлена опция Recursive query, которая позволяет получать расширенную версию WHOIS(контактные email адреса и т.п.)

- Добавлена поддержка XPath запросов, сильно упрощающая разбор HTML документов

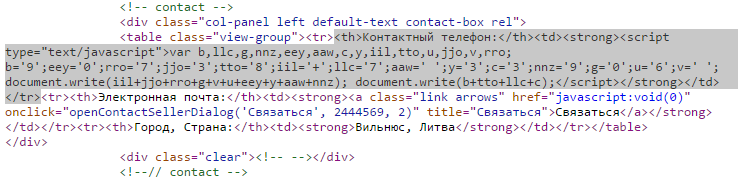

- Добавлен новый инструмент tools.js, позволяющий исполнять JavaScript из шаблонизатора, теперь помимо возможности использовать JavaScript для обработки и вывода результатов стало возможно частично исполнять скрипты встроенные в HTML(Выборочная обработка JavaScript: расшифровка телефонов)

Исправления в связи с изменениями в выдачи

Исправления в связи с изменениями в выдачи

- Исправлен парсинг рекламных объявлений в

SE::Google SE::Google

- Исправлен парсер

Rank::Ahrefs Rank::Ahrefs

- Исправлен парсер

Rank::DMOZ Rank::DMOZ

Исправления

- При использовании динамического имени файла append text теперь пишется один раз

- Исправлена работа с ссылками, которые содержат некоторые символы Юникода в

Net::HTTP Net::HTTP

- Исправлена обработка каптчи в

SE::Yandex::Register SE::Yandex::Register

- Исправлен парсинг подсказок в

SE::Google::Suggest SE::Google::Suggest

|

|

|

|

| |

С нами с 03.10.15

Сообщения: 4

|

Добавлено: 02/11/15 в 05:03 Добавлено: 02/11/15 в 05:03 |

Пользуюсь постоянно! Оперативная тех поддержка, частые обновления. Правда использую лишь малую часть из того, на что он способен!

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 03/11/15 в 08:11 Добавлено: 03/11/15 в 08:11 |

Сборник рецептов #11: парсим Авито, работаем с JavaScript, анализируем тексты и участвуем в акции!

Розыгрыш призов, условия акции смотри в конце!

11-й выпуск сборника рецептов. В нем мы разберем пример парсинга Авито, научимся расшифровывать телефонные номера, скрытые за JS и будем анализировать тексты.

Парсинг Авито

Если просмотреть сайты с вакансиями для фрилансеров, то можно увидеть, что очень часто требуется парсить популярный сайт объявлений avito.ru. Чаще всего в результате нужна база телефонов, реже - списки объявлений и цены. Данная информация может быть необходима маркетологам, для изучения ситуации на рынке, спамерам для рассылки смс и т.д...

Задачу по парсингу Авито можно решить также с помощью А-Парсера. О том как это сделать - читайте по ссылке выше.

Выборочная обработка JavaScript: расшифровка телефонов

Выборочная обработка JavaScript: расшифровка телефонов

Бывает, что при парсинге различных ресурсов можно наткнуться на информацию, которая скрыта скриптом на JavaScript. До недавнего времени A-Parser не умел обрабатывать JS, и такие сайты оставались в "зоне недоступности". Но начиная с версии 1.1.318 A-Parser научился выборочно работать с JS. Поэтому теперь есть возможность более эффективно парсить такие ресурсы и получать нужную информацию.

Как это делать и больше подробностей о поддержке JS в А-Парсере читайте по ссылке выше.

Анализ текста

Иногда возникает необходимость проанализировать спаршенный или написанный текст по различным параметрам (например: тошнота, водность, определить тематику и язык, найти наиболее повторяющиеся слова и т.п.). Для этого существует много различных приложений и онлайн-сервисов. Парсинг одного из таких сервисов будет показан по ссылке выше.

Почти 3 месяца назад у нас появилась Платная услуга по составлению заданий для А-Парсера. Она оказалась очень актуальна среди новых пользователей парсера, а также среди тех, у кого не хватает времени на его изучение. За время ее существования было составлено более 70 заданий, при этом 75% состояли из 2-х и более пресетов. Среднее время на составление одного заказа, от согласования деталей до получения готового набора пресетов, составляет около 4 часов. При этом, каждый пресет тщательно тестируется, а получаемый результат обсуждается с клиентом.

Так как A-Parser - это программа для парсинга различной информации, 26 ноября, во Всемирный день информации, будет разыграно:

- 5 пакетов прокси (100 потоков на месяц)

- 3 бесплатных составления 1-го задания для А-Парсера

В акции принимают участие все, кто ретвитнет нашу новость об этой акции в Twitter. Подписывайтесь на наши каналы в Twitter: русскоязычный @a_parser и англоязычный @a_parser_en и следите за новостями на сайте! Победители акции будут определены случайно с помощью сервиса random.org. Видео определения победителей будет выложено вместе с результатами акции.

Еще больше различных рецептов в нашем Каталоге примеров!

Предыдущие сборники:

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 27/11/15 в 10:48 Добавлено: 27/11/15 в 10:48 |

Снижение комиссии при оплате PayPro и Итоги акции

В связи с плохой проходимостью платежей в системе Interkassa было принято решение снизить комиссию PayPro до 3%. PayPro теперь является рекомендуемым способом оплаты, который принимает все популярные платежные системы: PayPal, Visa/MasterCard, QIWI, Yandex.Money, Wire Transfer

Напоминаю что всегда доступен прием WebMoney без комиссии

Одновременно с этим мы перевели Members Area на русский язык, добавили систему уведомлений на e-mail, а также готовим инструкцию по использованию нашего магазина

Итоги акции:

Итак, сегодня 26 ноября, а значит пора подводить итоги нашей акции!

Всего участников оказалось не так и много - 14 человек. Поэтому шансы получить 1 из 8-ми призов были довольно велики.

Было проведено определение победителей, видео по ссылке: http://files.a-parser.com/Video/Action_26_11_15.avi

Искренне поздравляем всех счастливчиков!

Искренне поздравляем всех счастливчиков! А те, кому не повезло в этот раз - не отчаивайтесь, вскоре будут новые акции! Поэтому следите за нашими новостями на сайте или в Твиттере.

Победители, для уточнения деталей и получения призов, свяжитесь через Твиттер с выигрышных аккаунтов с администрацией А-Парсера @a_parser.

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 08/12/15 в 10:48 Добавлено: 08/12/15 в 10:48 |

A-Paeser - 1.1.355 - улучшения работы с регионами в Google и Яндексе, новые методы API, множество исправлений

Улучшения

- В парсере

SE::Yandex теперь также собираются ссылки на колдунщики(внутренние сервисы Яндекса), что позволяет более точно определять позиции сайтов в выдаче SE::Yandex теперь также собираются ссылки на колдунщики(внутренние сервисы Яндекса), что позволяет более точно определять позиции сайтов в выдаче

- В парсере

SE::Yandex улучшено определение misspell(исправленных) запросов SE::Yandex улучшено определение misspell(исправленных) запросов

- В парсере

SE::Yandex домен Яндекса теперь выбирается автоматически в зависимости от выбранного региона SE::Yandex домен Яндекса теперь выбирается автоматически в зависимости от выбранного региона

- В парсере

SE::Google улучшена работа с сессиями SE::Google улучшена работа с сессиями

- В парсере

SE::Bing добавлен выбор локации SE::Bing добавлен выбор локации

- В интерфейсе парсера теперь доступен список последних сообщений с форума поддержки

- Для парсера

SE::Yandex добавлена поддержка турецкого домена yandex.com.tr SE::Yandex добавлена поддержка турецкого домена yandex.com.tr

- В парсере

Net::HTTP добавлена поддержка шаблонизатора в поле Cookies Net::HTTP добавлена поддержка шаблонизатора в поле Cookies

- Теперь у начального текста, формата результата и конечного текста, общее пространство переменных, что позволяет решать задачи по выводу статистики

- В макрос num добавлена возможность указать шаг итераций, формат {num:START:END:STEP}

- Добавлен новый метод API getParserInfo - выводит список всех доступных результатов, который может вернуть парсер

- Добавлен новый метод API update - обновляет исполняемый файл парсера до последней доступной версии, после успешного ответа A-Parser будет автоматически перезапущен

- Метод API info теперь дополнительно выдает список всех доступных парсеров

Исправления в связи с изменениями в выдаче

- В

SE::Google исправлено указание локации SE::Google исправлено указание локации

- В

SE::Bing исправлен парсинг серпа и связанных ключевых слов SE::Bing исправлен парсинг серпа и связанных ключевых слов

- В

SE::Yandex исправлен сбор сниппетов и анкоров SE::Yandex исправлен сбор сниппетов и анкоров

- В

SE::Yahoo исправлен парсинг выдачи и работа с региональными доменами SE::Yahoo исправлен парсинг выдачи и работа с региональными доменами

- Исправлены

Rank::Category, Rank::Category,  SE::Bing::Images, SE::Bing::Images,  SE::Bing::LangDetect, SE::Bing::LangDetect,  SE::Baidu, SE::Baidu,  SE::AOL, SE::AOL,  SE::Google::SafeBrowsing, SE::Google::SafeBrowsing,  SE::Yandex::Register SE::Yandex::Register

Исправления

- Исправлено игнорирование максимального числа активных заданий

- В парсере

HTML::LinkExtractor исправлена обработка относительных ссылок HTML::LinkExtractor исправлена обработка относительных ссылок

- Исправлена перезапись результатов при паузе\старте или при перезапуске парсера и одновременно включенной опции "Перезаписать файл"

- Исправлена работа функции tools.parseJSON если страница была декодирована в UTF-8

- Исправлен вывод результатов в Тестировщике заданий

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 15/12/15 в 11:45 Добавлено: 15/12/15 в 11:45 |

A-Parser: вводный видео урок, обзор возможностей

Денис Бартаев рассказывает о базовых возможностях A-Parser

В выпуске рассматриваются:

- Основные настройки рядового парсера на примере SE::Yandex

- Настройки Антигейт

- Настройки прокси с проверкой статуса и без

- Основные инструменты тестирования результатов парсинга

- Базовые методы работы с шаблонизатором результатов, переменные парсеров

- Примеры создания заданий, и описание процедуры работы с Редактором заданий

Подписывайтесь на наш канал!

A-Parser на СПИК 2015 - запись доклада Леонида Гроховского

A-Parser на СПИК 2015! Почти половина доклада посвящена обзору некоторых возможностей A-Parser

Как использовать парсеры для SEO? Как проверять индексацию страниц, как узнать позиции сайта. Об этом в докладе "Парсеры на службе у SEO-специалистов" рассказывает Леонид Гроховский. Подписывайтесь на его канал https://www.youtube.com/user/Grohovskiy

И на наш https://www.youtube.com/channel/UCvypGICrfCky8tPtebmIvQw

Тезисы:

- Проверка индексации сайтов

- Сбор сниппетов

- Парсинг подсвеченных слов из сниппетов

- Проверка позиций и входных страниц

- Сбор запросов и подсказок

- Определение частотности для списка запросов

- Парсинг VK

- Выкачивание базы у любого сайта

- Взаимодействие с A-Parser через API

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 25/12/15 в 11:34 Добавлено: 25/12/15 в 11:34 |

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 14/01/16 в 12:54 Добавлено: 14/01/16 в 12:54 |

A-Parser - 1.1.388 - новый парсер disconnect.me, улучшения в экспорте заданий

Улучшения

- Добавлен парсер

SE::DisconnectMe - поисковая система от бывших сотрудников Google, можно выбирать один из трех вариантов выдачи: Google, Bing, Yahoo SE::DisconnectMe - поисковая система от бывших сотрудников Google, можно выбирать один из трех вариантов выдачи: Google, Bing, Yahoo

- Теперь при сохранении пресета задания, сохраняется название файла запросов или сам список запросов

- При экспорте задания, появилась возможность указать включать или нет запросы в код пресета, а также теперь отображается список настроек парсеров которые будут включены в код

- В очереди заданий добавлена возможность свернуть\развернуть одновременно все задания на странице

- В очереди заданий для свернутых заданий теперь отображается время выполнения

- Увеличена скорость парсинга

SE::Google SE::Google

Исправления в связи с изменениями в выдачи

- В

SE::Google::Images больше не парсится параметр size SE::Google::Images больше не парсится параметр size

- Исправлены

SE::Google, SE::Google,  SE::Google::TrustCheck, SE::Google::TrustCheck,  SE::Google::Compromised, SE::Google::Compromised,  SE::Ask, SE::Ask,  SE::Dogpile, SE::Dogpile,  Rank::Mustat, Rank::Mustat,  Rank::Category, Rank::Category,  SE::AOL SE::AOL

Исправления

- A-Parser мог падать при использовании парсеров

SE::Yandex::WordStat, SE::Yandex::WordStat,  SE::Dogpile, а также при использовании Просмотра логов после перезапуска парсера SE::Dogpile, а также при использовании Просмотра логов после перезапуска парсера

- В парсере

Net::Whois не определялась дата экспайра для некоторых доменов Net::Whois не определялась дата экспайра для некоторых доменов

- В парсере

SE::Bing не корректно обрабатывались ссылки содержащие символ & SE::Bing не корректно обрабатывались ссылки содержащие символ &

Обновление партнерской программы

Участвуйте в нашей партнерской программе рекламируя A-Parser в своих блогах и на форумах! Размер комиссии - 15%:

- A-Parser Lite: $18

- A-Parser Pro: $30

- A-Parser Enterprise: $42

В обновленном интерфейсе доступна удобная статистика заработанных средств и выплат, а также список привлеченных пользователей

Подробнее про условия участия в партнерской программе читайте в соответствующем разделе

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 08/02/16 в 15:20 Добавлено: 08/02/16 в 15:20 |

A-Parser: видео урок по парсингу 2ГИС

Денис Бартаев рассказывает о парсинге информации о компаниях и их телефонов из базы 2ГИС

В выпуске рассматриваются

- Использование парсера-паука HTML::LinkExtractor и его настройка для фильтрации ссылок

- Работа с параметром Parse To Level

- Использование парсера Net::HTTP и его настройка для выборки данных со страницы с помощью регулярных выражений

- Создание Excel-таблицы из результатов парсинга

Подписывайтесь на наш канал!

Оставляйте в комментариях свои идеи и пожелания для будущих видео

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 15/02/16 в 11:44 Добавлено: 15/02/16 в 11:44 |

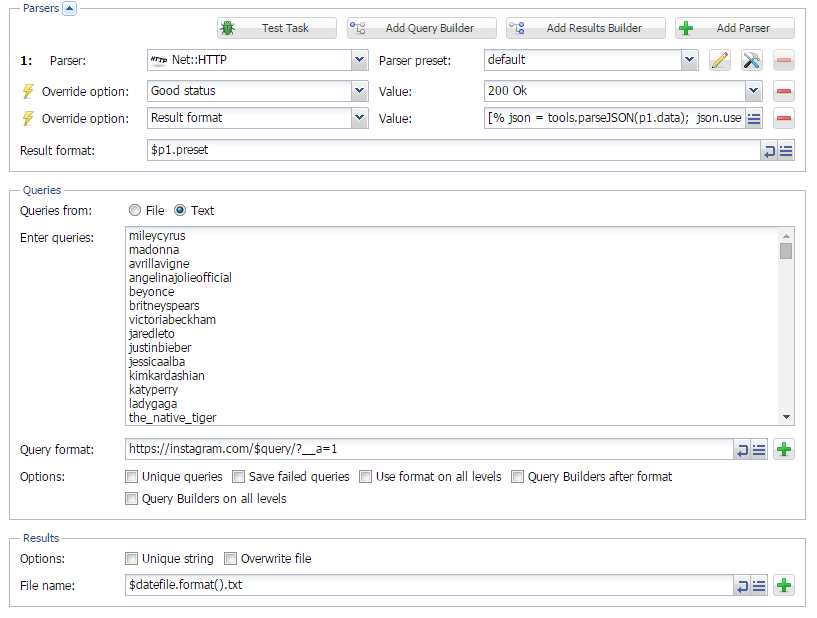

Сборник рецептов #12: парсим Instagram, собираем статистику и делаем свои парсеры подсказок

12-й выпуск Сборника рецептов. В нем мы рассмотрим пример парсинга Instagram, проверим новую возможность вывода статистики и научимся составлять кастомные парсеры подсказок. А также:

- Обзор вариантов представления результатов

- Универсальный чекер страниц

- Парсинг трафика и стоимости по ключевым словам из SEMrush

- Обновление и улучшение пресетов для парсинга Авито и 2GIS

Парсинг Instagram

Instagram на сегодня является одним из самых популярных приложений для обмена фото с элементами социальной сети (осенью 2015 года аудитория превысила 400 млн пользователей). Такая популярность делает данный сервис привлекательным для парсинга, с целью получения различной информации. Как парсить Инстаграм с помощью А-Парсера - по ссылке выше.

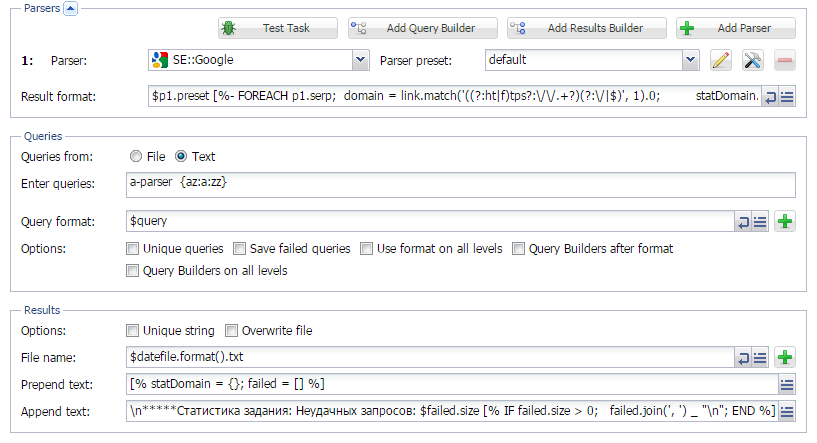

Статистика по результатам парсинга

Статистика по результатам парсинга

Начиная с версии 1.1.336 в А-Парсере появилась возможность вести и обрабатывать статистику парсинга, благодаря поддержке шаблонизатора в Начальном и Конечных текстах. Теперь в выдаче можно подсчитать количество ссылок на каждом домене, количество сабдоменов для каждого домена, частоту каждого сабдомена; получить списки доменов, имеющих сабдомены и многое другое... Несколько примеров показаны по ссылке выше.

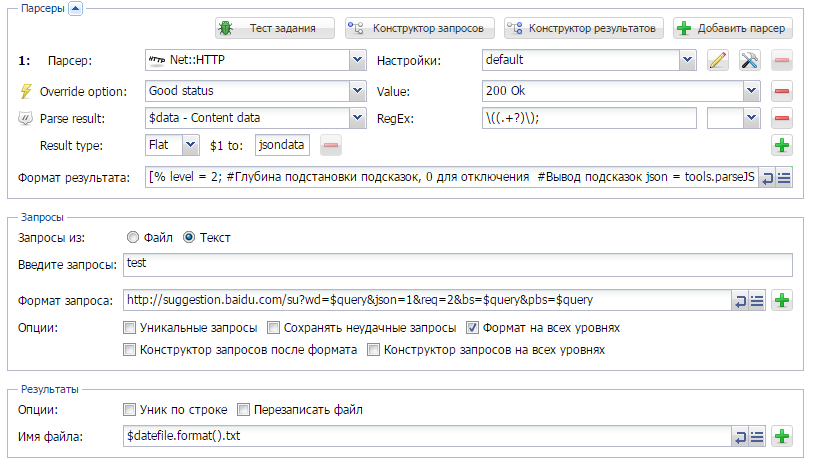

Как сделать свой парсер подсказок?

Как сделать свой парсер подсказок?

В A-Parser уже существуют парсеры подсказок для Google, Yandex, AOL, Bing и Yahoo. Но есть и другие сервисы, которые также выдают подсказки. О том, как сделать свой парсер подсказок, а также примеры для Baidu, Rambler, Mail.Ru, LiveInternet, DuckDuckGo и GooglePlay смотрите по ссылке выше.

Кроме этого еще несколько рецептов:

Кроме этого еще несколько рецептов:

Еще больше различных рецептов в нашем Каталоге примеров!

- Сборник рецептов #1: Определяем CMS, оцениваем частотность ключевых слов и парсим Вконтакте

- Сборник рецептов #2: собираем форумы для XRumer, парсим email со страниц контактов

- Сборник рецептов #3: мобильные сайты, несколько парсеров, позиции ключевых слов

- Сборник рецептов #4: поиск в выдаче, парсинг интернет-магазина и скачиваем файлы

- Сборник рецептов #5: ссылки из JS, паблик прокси и карта сайта

- Сборник рецептов #6: парсим базу номеров телефонов и сохраняем результаты красиво

- Сборник рецептов #7: парсим RSS, качаем картинки и фильтруем результат по заголовкам

- Сборник рецептов #8: парсим 2GIS, Google translate и подсказки Youtube

- Сборник рецептов #9: проверяем сезонность ключевых слов и их полезность

- Сборник рецептов #10: пишем кастомный парсер поисковика и парсим дерево категорий

- Сборник рецептов #11: парсим Авито, работаем с JavaScript, анализируем тексты и участвуем в акции!

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 29/02/16 в 10:02 Добавлено: 29/02/16 в 10:02 |

A-Parser - 1.1.434 - парсинг частотности Яндекс.Директ с большой скоростью, улучшения использования памяти

В этой версии проделана большая работа по добавлению поддержки агрегации запросов. Теперь парсер частотности ключевых слов  SE::Yandex::Direct::Frequency может получать данные со скоростью 20000-50000 слов\минуту

Улучшения

- Уменьшено потребление памяти при использовании большого числа потоков и\или нескольких парсеров в одном задании

- Уменьшено потребление памяти при большой очереди завершенных заданий

- В парсере

SE::Yandex::Direct::Frequency добавлена возможность выбрать все регионы или выбрать несколько определенных SE::Yandex::Direct::Frequency добавлена возможность выбрать все регионы или выбрать несколько определенных

- В парсере

SE::Yandex::Direct::Frequency добавлена поддержка Яндекс аккаунтов, а так же поддержка AntiGate и парсинг по 500 ключевых слов за один запрос SE::Yandex::Direct::Frequency добавлена поддержка Яндекс аккаунтов, а так же поддержка AntiGate и парсинг по 500 ключевых слов за один запрос

- В парсере

SE::Yandex::Direct::Frequency добавлена возможность выбора периода за последний месяц, за определенный месяц, за квартал или за год SE::Yandex::Direct::Frequency добавлена возможность выбора периода за последний месяц, за определенный месяц, за квартал или за год

- Для Windows и Linux улучшена поддержка юникода в именах файлах, независимо от языка интерфейса ОС

- Добавлена возможность просматривать логи только неудачных запросов

- В API добавлена возможность указать флаг removeOnComplete при добавлении задания, тем самым задания будут автоматически удалятся после завершения

- В просмотре логов теперь можно выделить данные для копирования

- В парсере

Net::HTTP добавлен параметр Max cookies count, ограничивающий число Cookie для сохранения Net::HTTP добавлен параметр Max cookies count, ограничивающий число Cookie для сохранения

- В парсере

Net::HTTP расширен список кодов ответов, а также добавлена возможность указать регулярное выражения для проверки кода ответа Net::HTTP расширен список кодов ответов, а также добавлена возможность указать регулярное выражения для проверки кода ответа

- В очереди заданий теперь можно искать необходимые задания по названию, номеру, подстроке в запросах, имени файлов запросов и результатов

- В парсере

HTML::LinkExtractor добавлена опция Check next page, позволяющая расширить логику перехода по ссылкам HTML::LinkExtractor добавлена опция Check next page, позволяющая расширить логику перехода по ссылкам

- Добавлена опция Page as new query, которая передает переход на следующую страницу как новый запрос, тем самым позволяя убрать ограничение на количество страниц для перехода

Исправления в связи с изменениями выдачи

- В парсере

SE::Yandex исправлен парсинг связанных ключевых слов SE::Yandex исправлен парсинг связанных ключевых слов

- В парсере SE::Youtube исправлен парсинг количества видео по запросу

- Исправлен парсинг Google Blogs в парсере SE::Google

- Исправлены

SE::AOL, SE::Ask, SE::Baidu, SE::Google, SE::Google::pR, SE::DisconnectMe, SE::QIP, SE::Yandex SE::AOL, SE::Ask, SE::Baidu, SE::Google, SE::Google::pR, SE::DisconnectMe, SE::QIP, SE::Yandex

Исправления

- Исправлено отображение длинных выпадающих меню

- Исправлена кодировка запросов в просмотре логов

- Исправлено падение при использовании опции Parse to level в некоторых ситуациях

- Исправлено падение в парсере

SEO::ping SEO::ping

- Прокси с авторизацией теперь сохраняются корректно в файл живых прокси alive.txt

- Исправлена работа с прокси при указании пустой пары логин\пароль для авторизации

- В парсере

SE::Yandex::WordStat теперь при использовании опции Remove + from keywords плюсы удаляются также для фраз правого столбика SE::Yandex::WordStat теперь при использовании опции Remove + from keywords плюсы удаляются также для фраз правого столбика

- Исправлено экранирование символа + в HTTP запросах

Все изменения и описания новых возможностей скоро будут доступны в документации

|

|

|

|

| |

С нами с 03.06.13

Сообщения: 278

Рейтинг: 37

|

Добавлено: 16/03/16 в 11:57 Добавлено: 16/03/16 в 11:57 |

|

|

|

|

| |

Текстовая реклама в форме ответа

Заголовок и до четырех строчек текста

Длина текста до 350 символов

Купить рекламу в этом месте! |

|

Спонсор сайта

|